4.3 서로 독립인 두 개의 랜덤 변수 Bivariate Independent Random Variables 페이지에서 두 랜덤 변수가 독립인 경우를 다루었다. 하지만 현실에서 측정치나 통계치들은 서로 연관되어 있는 경우가 훨씬 많다. 예를 들어, 한라산에서 각 지점의 고도와 온도를 측정하는 경우, 고도가 높을 수록 온도가 낮게 측정될 것이다. 또 다른 예로 종이의 크기와 무게를 측정하는 경우에도 이 두 값은 서로 연관되어 있다. 이 페이지에서는 이렇게 서로 연관되어 있는 랜덤 변수들이 얼마나 하게 연결되어 있는지를 보여주는 여러 지표 중 공분산과 상관계수에 대하여 살펴볼 것이다.

#Relation Between Random Variables?

먼저 랜덤 변수들이 강한 연관 관계에 있다는 것이 어떤 의미인지에 대하여 생각해보자. 앞에서 예로 든 종이의 크기와 무게는 거의 완벽히 연결되어 있다. 종이가 크면 무게도 무겁고, 종이가 작으면 무게도 가볍다. 종이에 대한 충분한 데이터가 주어진다면 종이의 크기만 알아도 무게를 계산해 낼 수 있고, 반대로 종이의 무게만 알아도 크기를 계산해 낼 수 있을 것이다. 그러나 성인의 키와 몸무게는 서로 연관되어 있지만 강하게 연결되어 있다고 할 수 없다. 보통은 키가 크면 몸무게가 더 나가겠지만, 꼭 키가 큰 사람이 작은 사람보다 몸무게가 더 나가는건 아니다. 따라서 키를 알아낸다고 해서 몸무게를 정확히 계산할 수 없고, 반대로 몸무게를 알아낸다고 해서 키를 정확히 계산해 낼 수는 없다. 즉, 강한 연관 관계인 경우에는 랜덤 변수들이 정확히 함수 관계에 있다고 할 수 있지만, 약한 약한 연관 관계인 경우에는 랜덤 변수들이 대략적으로만 특정 경향성을 가진다고 할 수 있다.

이번 페이지에서는 수식의 가독성을 위하여, \(X\) 의 평균을 \(E[X]\) 대신 \(\mu_X\), 분산을 \(\text{Var}(X)\) 대신 \(\sigma_X ^2\) 으로 표기한다.

#Covariance, Correlation

DEFINITION

Random variable \(X\) 와 \(Y\) 에 대하여, 다음 값을 \(X\) 와 \(Y\) 의 covariance(공분산)이라고 부른다.

\[ \text{Cov}(X,Y) = E[(X-\mu_X)(Y-\mu_Y)] \]

DEFINITION

Random variable \(X\) 와 \(Y\) 에 대하여, 다음 값을 \(X\) 와 \(Y\) 의 correlation 또는 correlation coefficient(상관 계수)라고 부른다.

\[ \rho_{XY} = \frac{\text{Cov}(X,Y)}{\sigma_X \sigma_Y} \]

당연히 실제 계산은 joint distribution에서 이루어진다. 예를 들어 \(X\) 와 \(Y\)가 연속인 경우, covariance는 다음과 같이 joint pdf의 적분을 통해 계산할 수 있다.

\[ \text{Cov}(X,Y) = \int (X-\mu_X)(Y-\mu_Y) f_{X,Y}(x,y)~dxdy \]

보통 covariance를 계산하기 위해 위의 정의를 그대로 사용하기 보다는 다음과 같은 형태로 변형하여 계산한다.

THEOREM

\[ \begin{equation} \text{Cov}(X,Y) = E[XY] - \mu_X \mu_Y \label{cov} \end{equation} \]

(증명)

\[ \begin{align*} \text{Cov}(X,Y) &= E[(X-\mu_X)(Y-\mu_Y)] \\ \\ &= E[XY-\mu_Y X - \mu_X Y + \mu_X\mu_Y] \\ \\ &= E[XY] - \mu_Y E[X] - \mu_X E[Y] + \mu_X\mu_Y \\ \\ &= E[XY] - \mu_X\mu_Y - \mu_X\mu_Y + \mu_X\mu_Y \\ \\ &= E[XY] - \mu_X\mu_Y \end{align*} \]

(증명 끝)

#Basic Properties of Covariance

Covariance는 다음과 같은 특징들을 갖는다.

THEOREM

Random variable \(X\), \(Y\), \(W\), \(V\), 상수 \(a\), \(b\), \(c\), \(d\) 에 대하여 다음이 성립한다.

1. \(\text{Cov}(X,X) = \text{Var}(X)\)

2. \(\text{Cov}(X,a) = 0\)

3. \(\text{Cov}(X,Y) = \text{Cov}(Y,X)\)

4. \(\text{Cov}(aX,bY) = ab \text{Cov}(X,Y)\)

5. \(\text{Cov}(X+a,Y+b) = \text{Cov}(X,Y)\)

6. \(\text{Cov}(aX+bY,cW+dV) = ac \text{Cov}(X,W) + ad \text{Cov}(X,V) + bc \text{Cov}(Y,W) + bd \text{Cov}(Y,V)\)

(증명)

1. variance의 정의와 covariance의 정의로부터 바로 얻어진다.

2. 상수 \(a\) 를 random variable처럼 이해하면, \(a\) 의 평균은 \(a\) 가 되므로 covariance의 정의로부터

\[ \text{Cov}(X,a) = E[(X-\mu_X)(a-a)] = 0 \]

3. covariance의 정의로부터

\[ \text{Cov}(X,Y) = E[(X-\mu_X)(Y-\mu_Y)] = E[(Y-\mu_Y)(X-\mu_X)] = \text{Cov}(Y,X) \]

4. random variable \(aX\) 와 \(bY\) 의 평균은 각각 \(a\mu_X\), \(b\mu_Y\)가 되므로

\[ \begin{align*} \text{Cov}(aX,bY) &= E[(aX-a\mu_X)(bY-b\mu_Y)] \\ \\ &= E[ab(X-\mu_X)(Y-\mu_Y)] \\ \\ &= ab E[(X-\mu_X)(Y-\mu_Y)] \\ \\ &= ab \text{Cov}(X,Y) \end{align*} \]

6. random variable \(aX+bY\) 와 \(cW+dV\) 의 평균은 각각 \(a\mu_X + b\mu_Y\), \(c\mu_W + d\mu_V\) 이므로

\[ \begin{align*} \text{Cov}(aX+bY, cW+dV) &= E[(aX+bY - a\mu_X - b\mu_Y)(cW+dV-c\mu_W-d\mu_V)] \\ \\ &= E[\left\{ a(X-\mu_X) + b (Y-\mu_Y)\right\}\left\{ c(W-\mu_W) + d(V-\mu_V) \right\} ] \\ \\ &= E[ac(X-\mu_X)(W-\mu_W)] + E[ad(X-\mu_X)(V-\mu_V)] \\ \\ & ~~~~~~~~+ E[bc(Y-\mu_Y)(W-\mu_W)] + E[bd(Y-\mu_Y)(V-\mu_V)] \\ \\ &= ac \text{Cov}(X,W) + ad \text{Cov}(X,V) \\ \\ & ~~~~~~~~+ bc \text{Cov}(Y,W) + bd \text{Cov}(Y,V) \end{align*} \]

(증명 끝)

#Covariance and Correlation of Indepedent Random Variables

왜 covariance와 correlation이 random variable들 사이의 연관 관계를 나타내는 값이라고 할까? 다음 정리를 살펴보자.

THEOREM

Random variable \(X\) 와 \(Y\) 가 서로 독립이면, \(\text{Cov}(X,Y)=0\) 이다.

(증명)

\(X\) 와 \(Y\) 가 서로 독립이면, \(E[XY] = E[X]E[Y] = \mu_X \mu_Y\) 이므로, 식 \((\ref{cov})\)로부터 \(\text{Cov}(X,Y)=0\).

(증명 끝)

따라서 독립인 경우 correlation도 0이 된다. 위 정리로부터 covariance나 correlation이 0이 아닌 값을 가지는 경우, 두 random variable은 서로 독립이 아니라는 뜻이 된다.

Example 1

다음과 같은 joint pdf에 대하여 covariance와 correlation을 구해보자.

\[ f_{X,Y}(x,y) = 1 ~~~~, ~0<x<1 \text{ and } x<y<x+1 \]

먼저 \(\mu_X\), \(\sigma_X ^2\), \(\mu_Y\), \(\sigma_Y ^2\) 를 구하기 위해, 각 random variable의 marginal pdf를 구하면,

\[ f_X(x) = \int _x ^{x+1} f_{X,Y}(x,y) ~dy = 1 \]

\[ f_Y(y) = \left\{ \begin{array}{llll} \int _0 ^y f_{X,Y}(x,y) dx & = & y & \text{when } 0<y<1 \\ \int _y ^2 f_{X,Y}(x,y) dx & = & 2-y & \text{when } 1\le y < 2 \end{array} \right. \]

따라서,

\[ \begin{align*} \mu_X &= \frac{1}{2} & \sigma_X ^2 &= \frac{1}{12} \\ \mu_Y &= 1 & \sigma_Y ^2 &= \frac{1}{6} \end{align*} \]

이제 covariance를 계산하기 위하여 \(E[XY]\) 를 계산하자.

\[ E[XY] = \int _0 ^1 \int _x ^x+1 xy ~dydx = \frac{7}{12} \]

식 \((\ref{cov})\)를 이용하여,

\[ \text{Cov}(X,Y) = E[XY] - \mu_X \mu_Y = \frac{1}{12} \]

그리고 correlation의 정의를 이용하여,

\[ \rho_{XY} = \frac{\text{Cov}(X,Y)}{\sigma_X \sigma_Y} = \frac{1}{sqrt{2}} \]

비교를 위하여 또 다른 joint pdf에 대하여 똑같은 계산을 해보자.

\[ g_{X,Y}(x,y) = 10 ~~~~, ~0<x<1 \text{ and} x<y<x+\frac{1}{10} \]

같은 방식으로 covariance와 correlation을 구해보면

\[ \begin{align*} \text{Cov}(X,Y) &= \frac{1}{12} & \rho_{XY} = \sqrt{\frac{100}{101}} \end{align*} \]

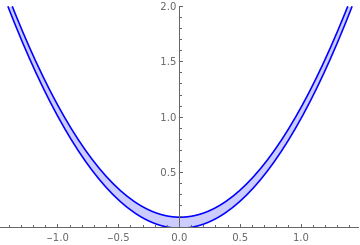

이 두 joint pdf의 support를 좌표평면에서 살펴보면 다음과 같다.

\(f_{X,Y}\) 와 \(g_{X,Y}\) 의 분포를 비교해보면, \(f_{X,Y}\) 의 경우 \(Y\) 가 더 넓게 균등히 분포해 있기 때문에 이 페이지 처음 논의에 의하면, 더 약한 연관 관계에 있다고 할 수 있다. \(g_{X,Y}\) 의 경우 \(X\) 값을 알게 되면, \(Y\) 는 상당한 정확도로 값을 예측할 수 있기 때문에 더 강한 연관 관계라고 할 수 있을 것이다. 그러나 covariance 값은 두 경우 모두 \(\frac{1}{12}\) 로 동일하다. 이는 각 경우 variance가 서로 다르기 때문인데, 이렇게 두 연관 관계를 서로 비교하는 경우에는 covariance의 값을 standard deviation으로 나눈 correlation이 더 유용한 값이라는 것을 알 수 있다.

#Linear Relation

covariance와 correlation에서 주의해야 할 것은, 위 정리의 역은 성립하지 않는다는 것이다. 즉, 두 random variable이 독립이면 covariance와 correlation이 0이지만, 반대로 covariance와 correlation이 0이라고 해서 두 random variable이 반드시 독립인건 아니다. 다음의 예제를 살펴보자.

Example 2

Random variable \(X\) 는 uniform \((-1,1)\) distribution을 따르고 \(X\) 와 독립인 random variable \(Z\) 는 uniform \((0,\frac{1}{10})\) distrubution을 따른다고 하자. 여기에서 새로운 random variable \(Y=X^2 +Z\) 를 정의하면, \(Y\) 는 \(X=x\) 로 주어졌을 때, \((x^2,x^2+\frac{1}{10})\) 에 균등하게 분포된다. 이 분포의 joint pdf를 구하면 다음과 같다.

\[ f_{X,Y}(x,y) = 5 ~~~~,~-1<x<1 \text{ and } x^2 < y <x^2 + \frac{1}{10} \]

이 분포는 당연히 \(X\) 와 \(Y\) 가 서로 독립이지 않다. 오히려 상당히 강한 연관 관계를 가진다.

이제 이 분포의 covariance를 구해보자.

\[ \begin{align*} \text{Cov}(X,Y) &= E[XY] - E[X]E[Y] \\ \\ &= E[X(X^2+Z)] - E[X]E[X^2+Z] \\ \\ &= E[X^3+XZ] - E[X](E[X^2+Z]) \\ \\ &= E[X^3] + E[X]E[Z] - E[X]E[X^2] - E[X]E[Z] \end{align*} \]

이 때 \(X\)는 -1부터 1까지 균등하게 분포되어 있으므로 \(E[X]=E[X^2]=E[X^3]=0\) 이다. 따라서 \(\text{Cov}(X,Y)=0\) 이다.

위 예제에서 \(X\) 와 \(Y\) 는 상당히 강한 연관 관계인데도 불구하고 covariance와 correlation이 0이 된다. 왜 이렇게 되는 것일까? 그것은 covariance와 correlation은 여러 연관 관계 중 선형 관계만을 표현하는 지표이기 때문이다.

THEOREM

1. \(\begin{equation} -1 \le \rho_{XY} \le 1 \label{cor} \end{equation} \)

2. \(\left| \rho_{XY} \right| = 1 ~~~ \Leftrightarrow~~~P(Y=aX+b) = 1\) 을 만족하는 \(a\ne 0\), \(b\) 가 존재한다.

3. \(\rho_{XY} =1\) 인 경우 2번에서 \(a>0\), \(\rho_{XY}=-1\) 인 경우 \(a<0\).

이 정리에 따르면, 만약 \(X\) 와 \(Y\) 의 분포가 어떤 직선 \(y=ax+b\) 에 몰려있다고 한다면, correlation은 -1 또는 1에 가까운 값이 될 것이다. 그러나 그러한 직선이 존재하지 않는다면, correlation은 0이 될 것이다. 위의 예제는 그러한 직선이 존재하지 않기 때문에 correlation이 0이 된 것으로 해석할 수 있다. Example 1의 경우 \(f_{X,Y}\) 와 \(g_{X,Y}\) 의 correlation을 비교해보면, \(g_{X,Y}\) 가 1에 더 가깝다. 분포 그래프에서도 \(g_{X,Y}\) 가 더 직선에 가깝게 분포해 있음을 알 수 있다.

(증명)

1. 다음과 같은 함수 \(h(t)\) 를 정의해보자.

\[ h(t) = E\left[ \left\{ (X-\mu_X)t + (Y-\mu_Y) \right\}^2 \right] \]

이 함수를 \(t\) 로 전개하면,

\[ \begin{align*} h(t) &= E\left[(X-\mu_X)^2 \right] t^2 + 2E[(X-\mu_X)(Y-\mu_Y)]t + E\left[ (Y-\mu_Y)^2 \right] \\ \\ &= \sigma_X ^2 t^2 + 2\text{Cov}(X,Y) t + \sigma_Y ^2 \end{align*} \]

\(h(t)\) 는 정의상 random variable의 제곱의 기대값이므로 \(t\)의 값과 상관없이 언제나 0보다 크거나 같아야 한다. 따라서 \(t\) 에 대한 2차 함수가 \(t\) 의 값과 상관없이 언제나 0보다 크거나 같을 조건

\[ (\text{Cov}(X,Y))^2 - \sigma_X ^2 \sigma_Y ^2 \le 0 \]

정리하면,

\[ -\sigma_X \sigma_Y \le \text{Cov}(X,Y) \le \sigma_X \sigma_Y \]

따라서,

\[ -1 \le \rho_{XY} \le 1 \]

2. \(\left| \rho_{XY} \right| = 1\) 이기 위해서는 위의 증명에서 판별식=0 이어야 한다. 즉, \(h(t)=0\) 인 점이 중근을 가져야 한다. 그러나 \(h(t)\) 는 정의상 random variable의 제곱의 기대값이므로 그 외의 모든 경우 0보다 크다. 따라서

\[ P\left( [(X-\mu_X)t + (Y-\mu_Y)]^2 = 0\right) = 1 \]

이어야 한다. 따라서 중근에서는

\[ P\left( (X-\mu_X)t + (Y-\mu_Y) = 0\right) = 1 \]

가 성립한다. 이를 다시 정리하면,

\[ P\left( Y=-tX - \mu_Xt + \mu_Y \right) = 1 \]

3. \(h(t)=0\) 일 때, 2차 방정식의 근의 공식으로부터 \(t=-\frac{\text{Cov}(X,Y)}{\sigma_X ^2}\) 를 얻는다. 따라서 3번 내용이 성립한다.

(증명 끝)

#Advanced Topics

1. Relationship between covariances and inner products

Covariance의 기본 성질들을 살펴보면, inner product1의 정의와 일치한다는 것을 알 수 있다. 실제로 연속인 random variable들의 집합을 mean zero를 equivalence relation으로하여 quotient set을 정의하고, second moment가 finite한(즉, variance가 존재하는) random variable만으로 부분 집합을 만들면 이 집합은 vector space가 된고 covariance는 이 vector space의 real-valued \(L^2\) inner product가 된다. 이러한 관점에서 식 \((\ref{cor})\)은 사실상 Cauchy-Schwarz inequality를 적용하는 것과 같다. 따라서 다음과 같이 Cauchy-Schwarz inequality를 증명하는 방식으로도 증명할 수 있다.

다음과 같은 random variable \(Z\) 를 정의하자.

\[ Z = X - \frac{\text{Cov}(X,Y)}{\sigma_Y ^2}Y \]

그러면 covariance의 성질에 의하여,

\[ \begin{align*} 0 \le \sigma_Z ^2 &= \text{Cov}(Z,Z) \\ \\ &= \text{Cov}\left( X - \frac{\text{Cov}(X,Y)}{\sigma_Y ^2}Y, X - \frac{\text{Cov}(X,Y)}{\sigma_Y ^2}Y \right) \\ \\ &= \sigma_X ^2 - \frac{(\text{Cov}(X,Y))^2}{\sigma_Y ^2} \end{align*} \]

만약 random variable을 복소수 영역까지 확장시킨다면, inner product의 정의로부터 covariance의 성질 \(\text{Cov}(X,Y)=\text{Cov}(Y,X)\) 는 다음과 같이 수정되어야 한다.2

\[ \text{Cov}(X,Y) = \overline{\text{Cov}(Y,X)} \]

이러한 성질을 만족하도록 covariance를 다음과 같이 재정의할 수 있다.

DEFINITION

Random variable \(X\) 와 \(Y\) 에 대하여, 다음 값을 \(X\) 와 \(Y\) 의 covariance라고 부른다.

\[ \text{Cov}(X,Y) = E \left[(X-\mu_X)\overline{(Y-\mu_Y)} \right] \]

- inner product의 자세한 내용은 (선형대수학) 4.1 Inner Product Space 참고 [본문으로]

- \\(\\overline{A}\\)는 \\(A\\)의 complex conjugate이다. [본문으로]

'Mathematics > 통계학' 카테고리의 다른 글

| [통계학] 4.6 다변량 분포 Multivariate Distributions (0) | 2021.08.10 |

|---|---|

| [통계학] 4.5-(2) Example: 이변량 정규 분포 Bivariate Normal Distribution (1) | 2021.08.09 |

| [통계학] 4.5-(1) Example: 랜덤 변수 덧셈의 분산 Variance of the Addition of Random Variables (0) | 2021.08.09 |

| [통계학] 4.4-(2) Example: 서로 독립인 정규 분포의 덧셈과 차 (0) | 2021.08.07 |

| [통계학] 4.4-(1) Example: 계층적 확률 모델링 (0) | 2021.07.04 |

| [통계학] 4.4 랜덤 변수의 변환 (2) Transformations of Random Variables (2) (2) | 2021.03.02 |